マルチテナント for SAN

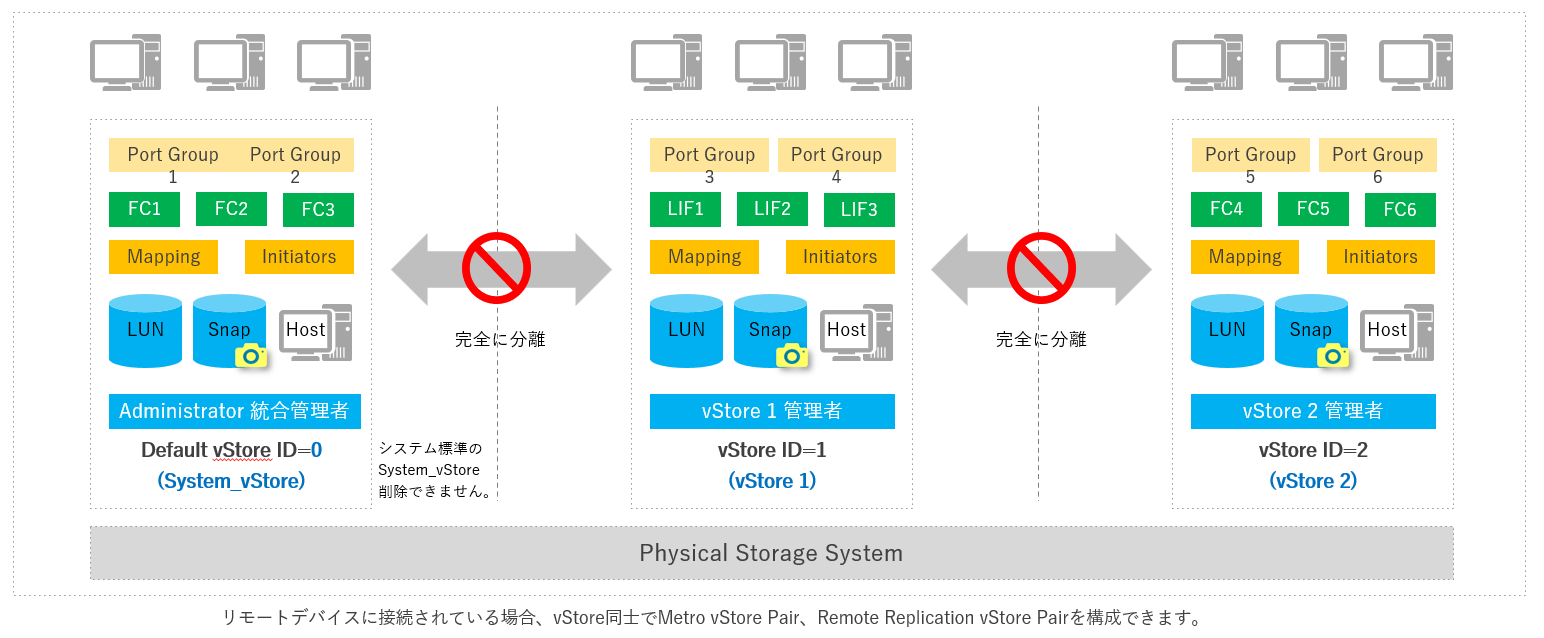

マルチテナントは、仮想ストレージ機能を提供します。仮想ストレージはvStoreと呼ばれ、ブロックサービス(LUN、Host、Port、Vvol、Mapping、QoS、マイグレーション)、インターフェース(FC、LIF)、データプロテクション(スナップショット、クローン、CDP、Metro、レプリケーション)を各vStore毎に完全に分離させた運用が可能です。

QoS for SAN

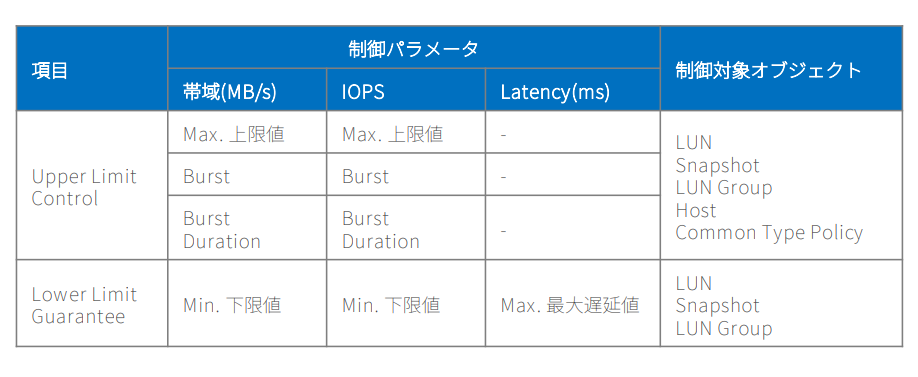

QoSは、オブジェクト固有のI/O優先度スケジューリングとI/Oトラフィック制御(上限制御と下限保証を含む)を使用して、アプリケーション毎のホストI/Oサービス品質を保証します。

Intelligent Quality of Service Control for SAN

Lower Limit Guarantee(下限保証機能)は、重要なサービスに対する最低性能を保証するために利用します。システム内のすべての制御対象オブジェクト(LUN、スナップショット、LUNグループなど)に対して、下限目標が設定されていないオブジェクトの性能リソースを解放し、下限目標が設定されているオブジェクトへ優先的に配当します。

QoSは、Control PolicyとしてCommon Type PolicyとHierarchical Type Policyの2種類のポリシーをサポートします。

Common Type Policyは、制御対象オブジェクトに対する1つのポリシーを設定します。

Hierarchical Type Policyは、複数のCommon Type Policyを階層的に管理し、Lower Limit Guaranteeをサポートしません。

Burst Traffic Control Management

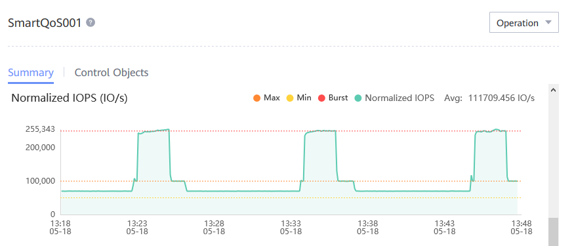

Lower: 5,000 IOPS

Upper: 100,000 IOPS

Burst: 250,000 IOPS

Burst 指定期間 120秒

平均70,000 IOPSで負荷を生成し、10分毎に3分間 250,000 IOPS以上のピーク負荷を発生

QoSは、Burst Traffic Control Managementにより、制御対象オブジェクトに対する Burst時のIOPS、帯域幅、および期間を指定することで、特定期間だけ上限を超えることを許可します。

システムはオフピーク時に未使用のリソースを蓄積し、トラフィックバースト中にそれらを消費して、短時間の間上限を超えることを可能とします。 これを実現するには、サービスの長期的な平均トラフィックが上限値を下回る必要があります。

マイグレーション for SAN

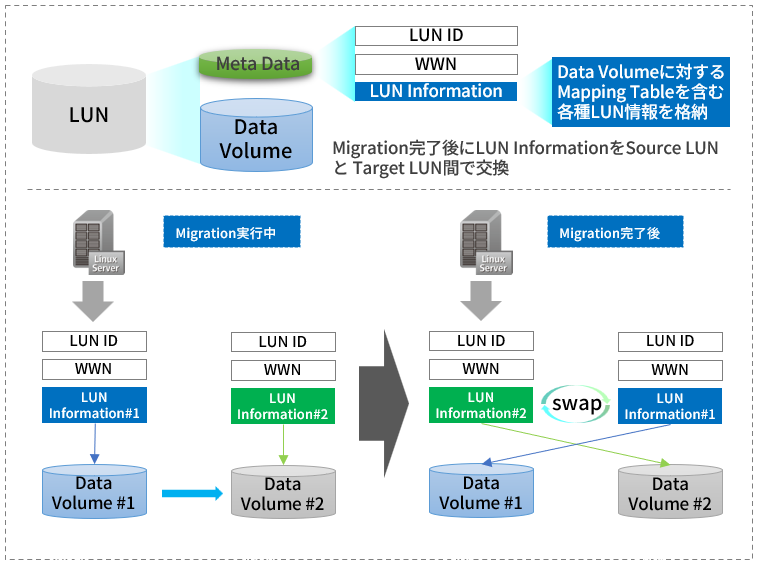

マイグレーションはホストサービスを中断することなく、Source LUNの完全な物理コピーをTarget LUNに作成し、データ移行完了後にSourceとTargetのLUN情報を交換することで、アクセス先をTarget LUNに変更します。

Migration Dual-Write Technology

LUN Information Exchange

Virtualization for SAN

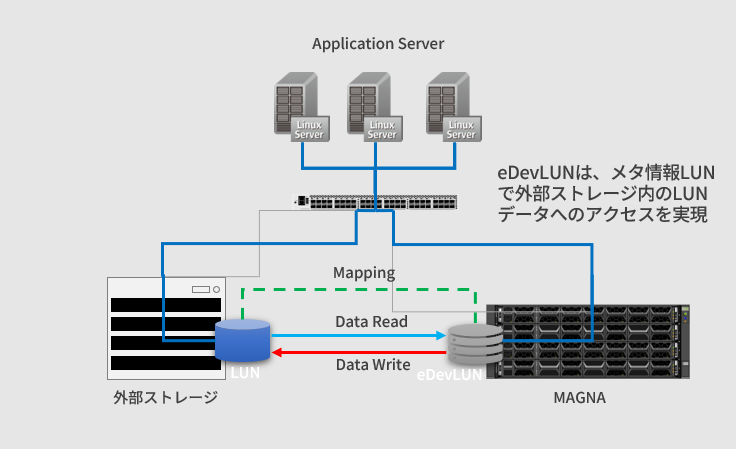

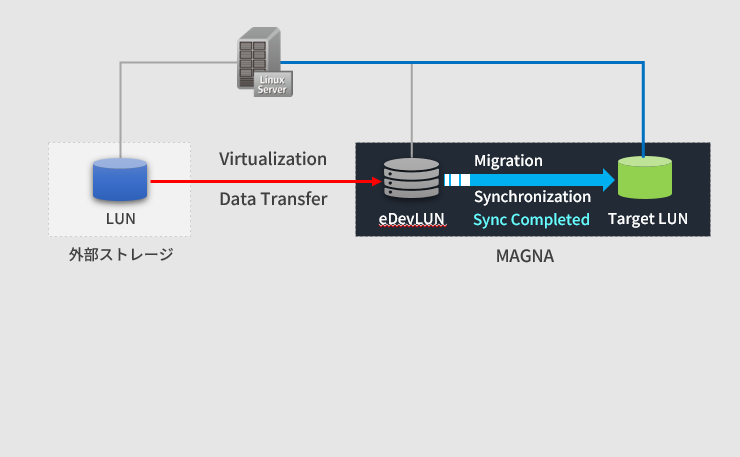

外部ストレージ内のLUNリソースをMAGNA内に理論的な外部デバイスLUN(eDevLUN)として取り込み、eDevLUNに対するホストサービスの提供やマイグレーションとの組み合わせによるLUN移行をサポートします。

Virtualization Working Principle

外部ストレージとMAGNA間の接続は、ホストサービスを提供するネットワーク経由ではなく、FCまたはiSCSIによるスイッチまたは直接接続するためのバックエンドネットワークを別途用意していただく必要があります。

Storage Migration with Migration

外部ストレージがMAGNAの旧モデルで且つホストがMultipathを採用している場合は、ホストサービスを停止することなくデータ移行が可能なOnline Take Overをサポートします。

Online Take Overは、eDevLUNをMasquerading Modeで生成することで、eDevLUNのWWNが外部ストレージ上のLUNと同一となります。Multipathは、Masquerading Modeで追加されたeDevLUNへのアクセスパスを追加しますので、無停止でアクセス先をeDevLUNに変更が可能となります。

Online Take Overが利用できない構成ではOffline Take Overとなりますので、外部ストレージからMAGNAのeDevLUNへマッピングを切り替える際に、一時的なサービス停止が必要となります。

スナップショット for SAN

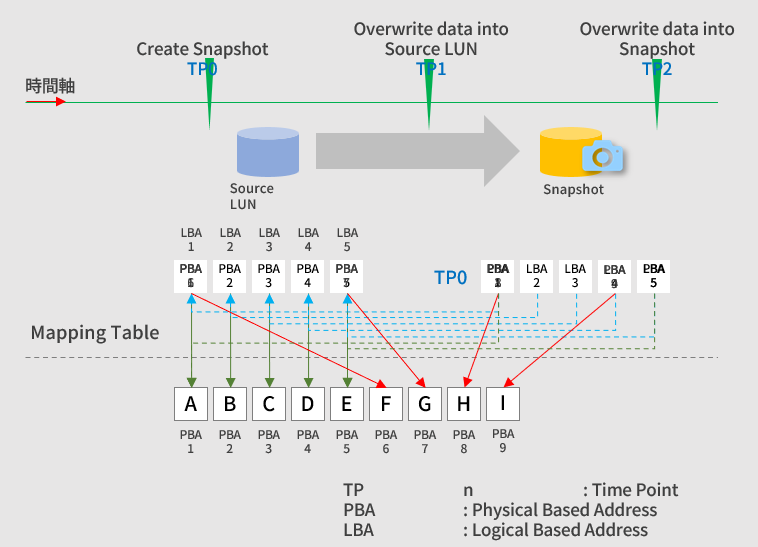

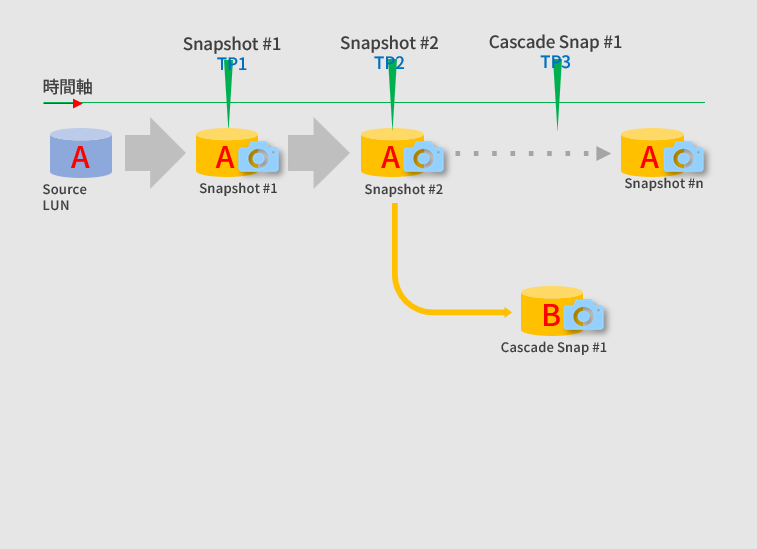

MAGNAシリーズはタイムポイント(TP)テクノロジーを利用したROWベースのWritableスナップショット機能を提供します。また、Snapshot Cascadingに対応しており、最大8レベルのCascade Snapshotを作成できます。

ROW based Snapshot Technology

Cascade Snapshot

スナップショットは、あるTP時点におけるSource LUNの状態を保持しますが、Cascade Snapshotは、あるTP時点のSource Snapshotの状態を保持します。

スナップショットは指定時間に自動取得するTiming Snapshot機能には対応していません。BCManagerもしくはRestful API等による外部コマンドを利用する必要があります。

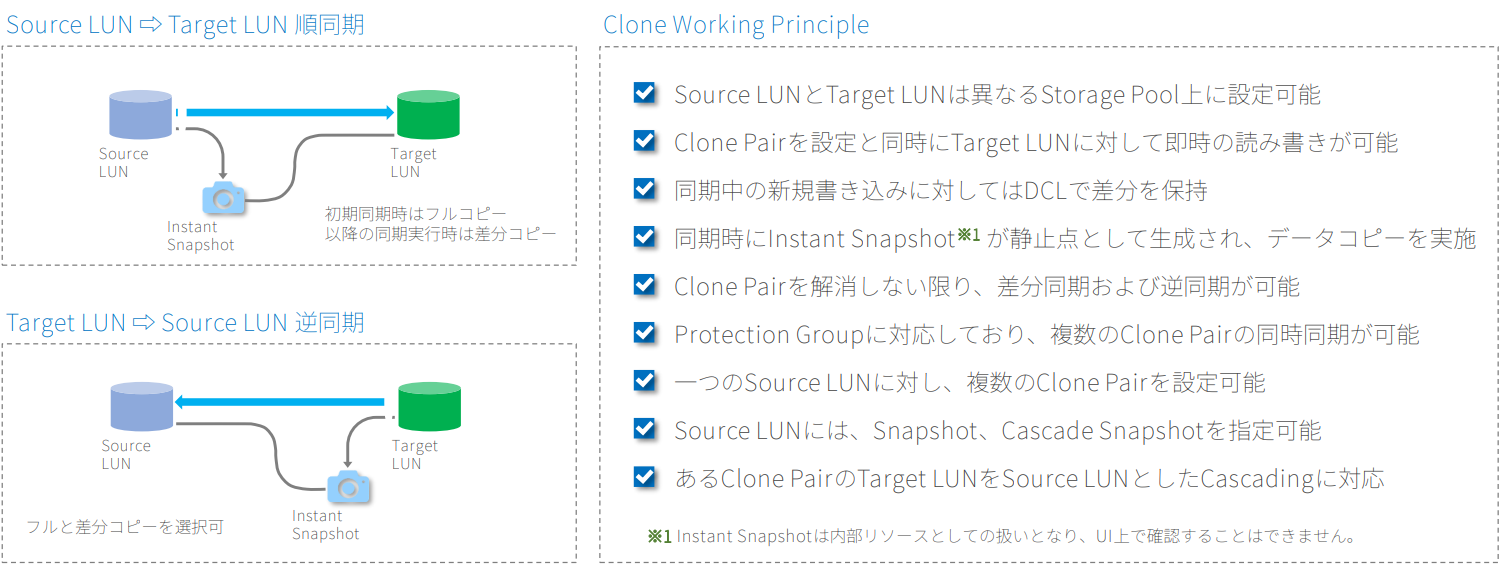

クローン for SAN

クローンは、Source LUNの完全な物理コピーをTarget LUNに生成します。Target LUNは既存データを含んでいても構いませんが、Source LUNと同一サイズでなければなりません。Target LUNの既存データは同期処理により Source LUNのデータで上書きされます。

CDP for SAN

CDP(Continuous Data Protection)は、ROWベースの軽量スナップショットを断続的に作成し、高密度なデータ保護を実現する機能です。最小3秒間隔でスナップショットを取得可能で、リストアを高速に行えるため誤操作によるデータ削除やウィルス等の感染からデータを保護するのに最適なソリューションです。

CDP Snapshot

CDPは、Source LUNに対して複数時点のスナップショットを継続的に作成します。

各CDPスナップショットは、作成時点におけるSource LUNのメタ情報だけを保持するため、高密度で容量オーバーヘッドが少なく、長期的にデータのリカバリポイントを確保できます。

| 項目 | 説明 |

|---|---|

| 最大取得数 |

モデルに依存(エントリーで100万、ハイエンドで200万) |

| スケジュール指定 |

Every:3~59秒毎、1~59分毎、1~24時間毎から指定 |

| 最大保持数指定 |

Everyスケジュール指定時:オブジェクトあたり60,000 |

| 複数LUN同期指定 |

Protection GroupとConsistency Group指定により可能 |

| 必要CDP領域の目安 |

対象LUN総容量の30%を推奨 |

| ホストマッピング |

CDPスナップショットを直接ホストにマッピングするのは不可だが、CDPスナップショットからスナップショットコピーを行えばホストへマッピング可能 |

レプリケーション for SAN

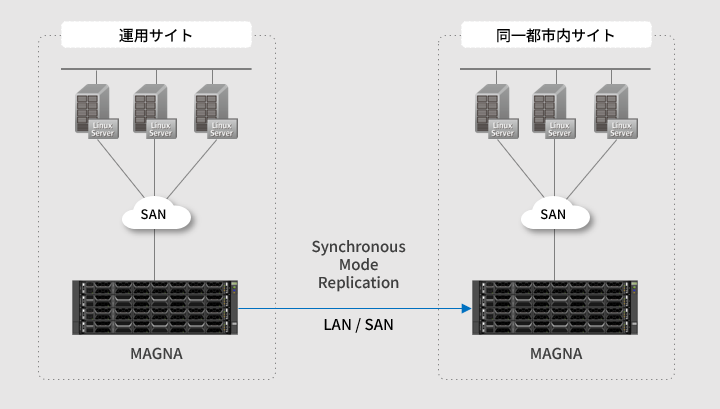

同期モード:Replication / S

サイト間が短距離の場合は、同期モードを利用することでサイト間のデータをリアルタイムで同期させ、RPO≒0を実現します。

同期モードはサイト間のRTTがおよそ1ms以下の場合に利用可能です。

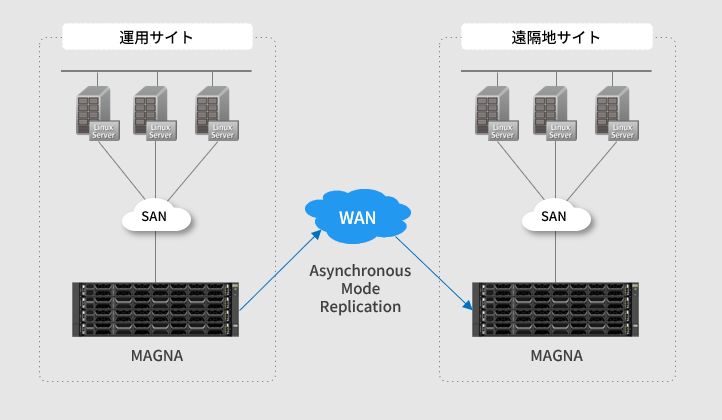

非同期モード:Replication / A

サイト間が遠距離の場合は、非同期モードを利用します。

先端技術により、ホストI/Oへの影響を抑え、非同期レプリケーションにも関わらず秒レベル(最短3秒)のRPOを実現します。

Replication / S for SAN:同期モード

Replication / Sは、アレイ間でデータをリアルタイムで同期させることでデータの一貫性を最大限に高め、災害時のデータ損失を最小限に抑えます。

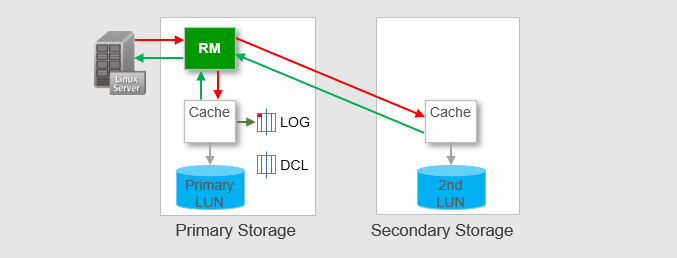

正常運用時

ホストI/OはRM(Replication Management module)により、Cache経由でPrimary LUNと2nd LUNの双方に対してリアルタイムで同期処理が行われます。

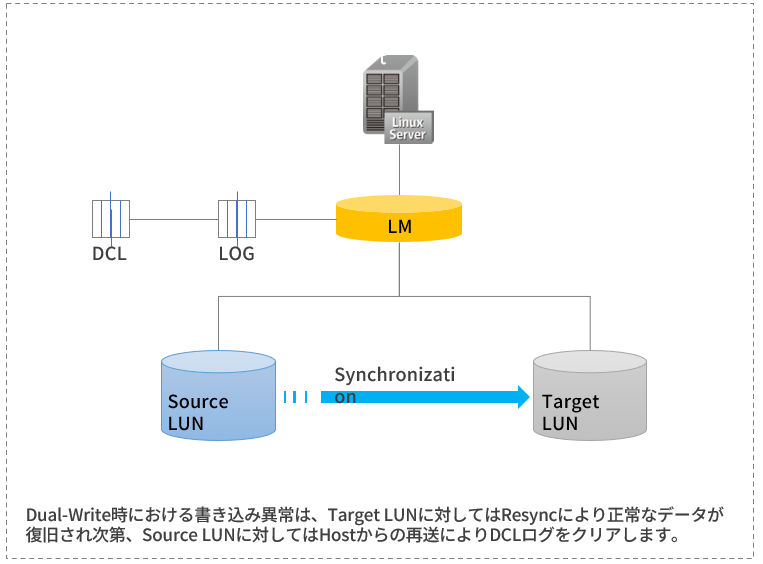

RM(Replication Management module)

Remote Replication構成におけるホストI/Oの処理を管理するモジュールで、Replication PairとなっているLUNへのDual Writeや、Split時のSingle Writeを制御します。

LOG(differential data LOG)

ホストからデータを受信した際、Primary側で即時に差分情報をログとして保存し、2nd LUN側でデータが正常に処理された際の返信によりログを消去します。

DCL(Data Change Log)

Secondary Storage側との通信が切断されたり、その他の異常により2nd LUNとの同期がとれなくなった場合に、再同期までの期間における差分情報(LOG)を保存するための専用ログです。

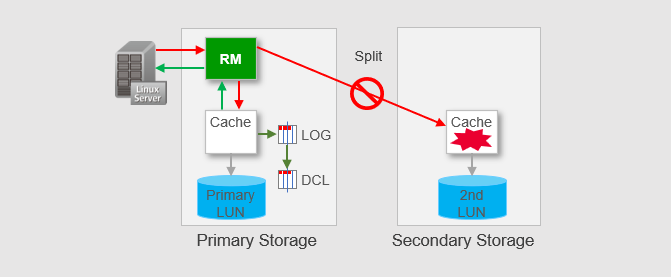

異常発生時

ホストI/OはRM(Replication Management module)により、Cache経由でPrimary LUNと2nd LUNの双方に対してリアルタイムで同期処理が行われます。

RM(Replication Management module)

Remote Replication構成におけるホストI/Oの処理を管理するモジュールで、Replication PairとなっているLUNへのDual Writeや、Split時のSingle Writeを制御します。

LOG(differential data LOG)

ホストからデータを受信した際、Primary側で即時に差分情報をログとして保存し、2nd LUN側でデータが正常に処理された際の返信によりログを消去します。

DCL(Data Change Log)

Secondary Storage側との通信が切断されたり、その他の異常により2nd LUNとの同期がとれなくなった場合に、再同期までの期間における差分情報(LOG)を保存するための専用ログです。

Replication / A for SAN:非同期モード

Replication / Aは、アレイ間でデータを定期的に同期させるリモートレプリケーション技術で、長距離転送における待ち時間とパフォーマンスの低下を最小限に抑えます。

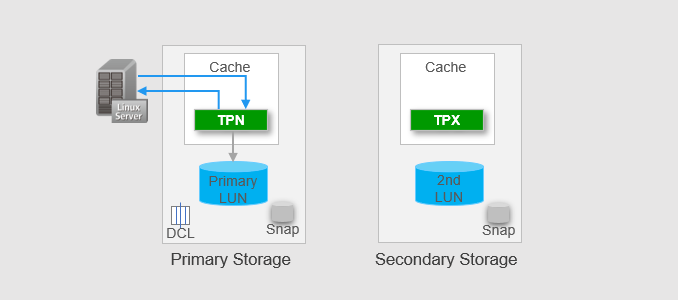

同期開始前

Primary LUNと2nd LUNにスナップショットは停止(Deactivate)しており、ホストI/Oは TPN Segment経由でPrimary LUNにディステージされていきます。

TPN Segment

Cache内のMulti-time-segmentであり、Primary LUNに対する同期開始前の期間(Time Period)における更新分を処理する領域です。通常のホストI/OはTPN segmentに書き込みが完了すると 、ACK がホストに返されます。

TPX Segment

Primary LUNに障害が発生し、2nd LUNへSwitch Overすることで、2nd LUN側をプライマリとして利用する際に使う領域です。

Multi-time-segmentのディステージ

各Multi-time-segmentにはHigh-water markが設定されており、Cache内のデータがHigh-water mark に達すると、メモリ内のデータをSSDへディステージします。

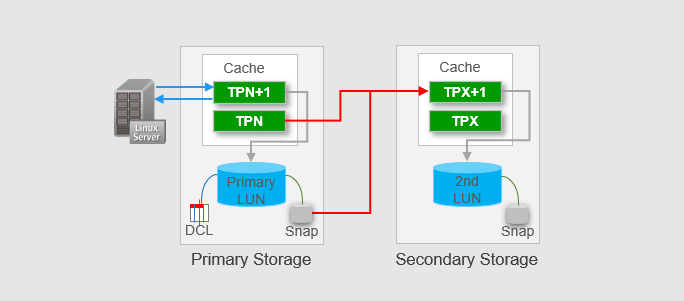

同期処理時

PrimaryおよびSecondary LUNで同期時点のスナップショットがActivateされ、TPN Segmentは同期時点までのデータを保持するため、新たなデータ更新用のTPN+1と TPX+1 Segmentが生成されます。

同期処理

同期処理は、Primary LUNでActivateされたSnapshot及び、同期時点までのデータを保持する TPN segmentからSecondary StorageのTPX+1 segmentに転送されます。TPX+1 segmentが High-water markに達するとSSDへディステージされます。

Secondary Storage側のSnapshot

Secondary Storage側のSnapshotは、同期が中断または失敗した際に、前回の同期完了時点にデータを復元するために確保されています。

同期処理中のホストI/O

同居処理実行中のPrimary Storage側におけるホストからのI/O処理要求は、TPN+1 Segmentが利用され、差分情報はDCLに書き込まれます。

Metro for SAN

外部Gateway装置を必要としないMAGNA本体のみで構成されるActive-Active Solutionで、同一DC内または同一都市内など、ネットワーク遅延の少ない2つの拠点間で完全な並列アクセスを実現します。

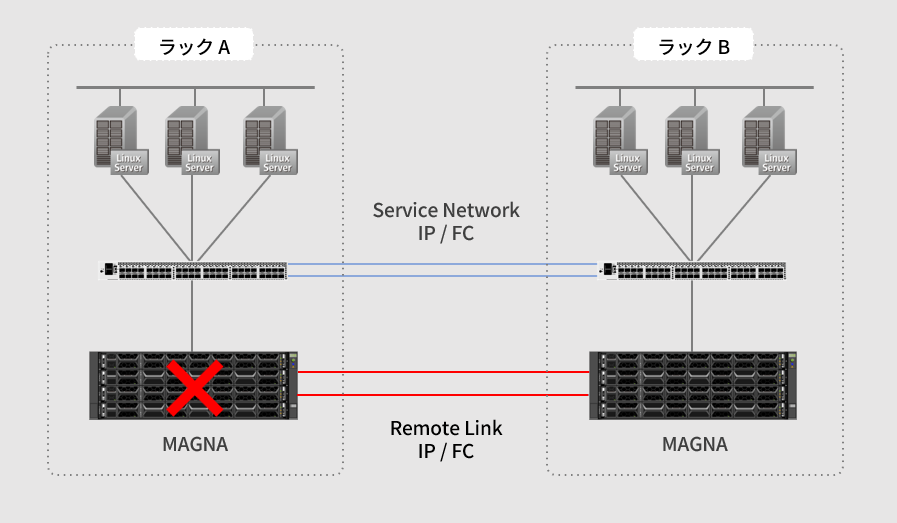

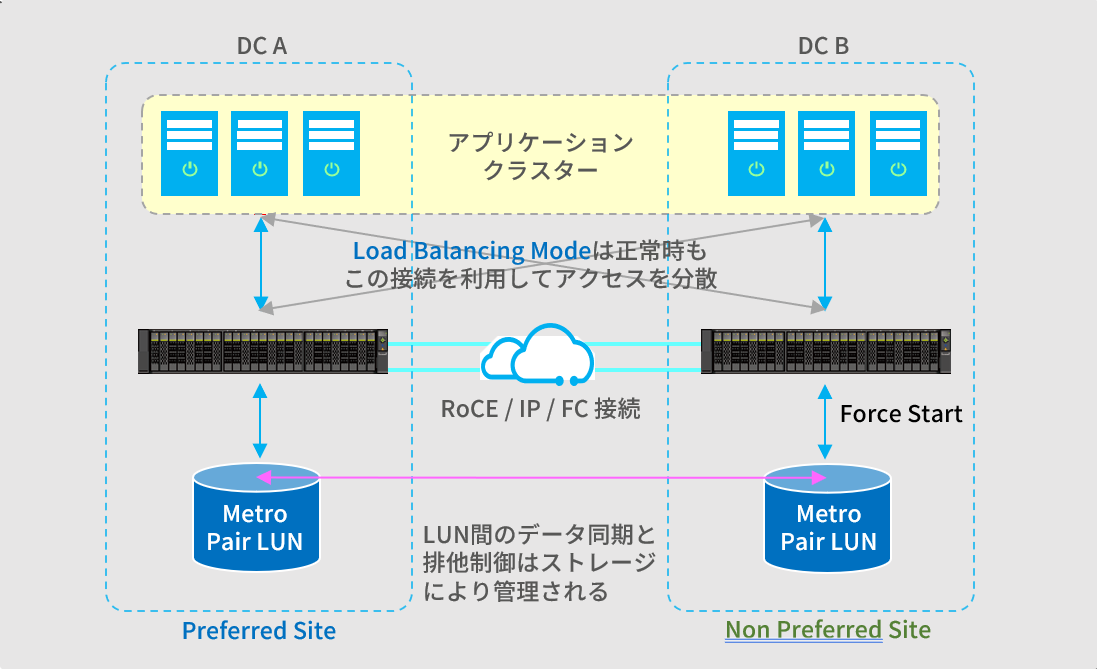

同一DC内:Load Balancing Mode

Load Balancing Modeは、同一DC内で遅延のないRemote Linkを構成できる場合に利用します。

アプリケーションサーバは2台のMAGNA に対して、常に等価(並列)でアクセスを行います。

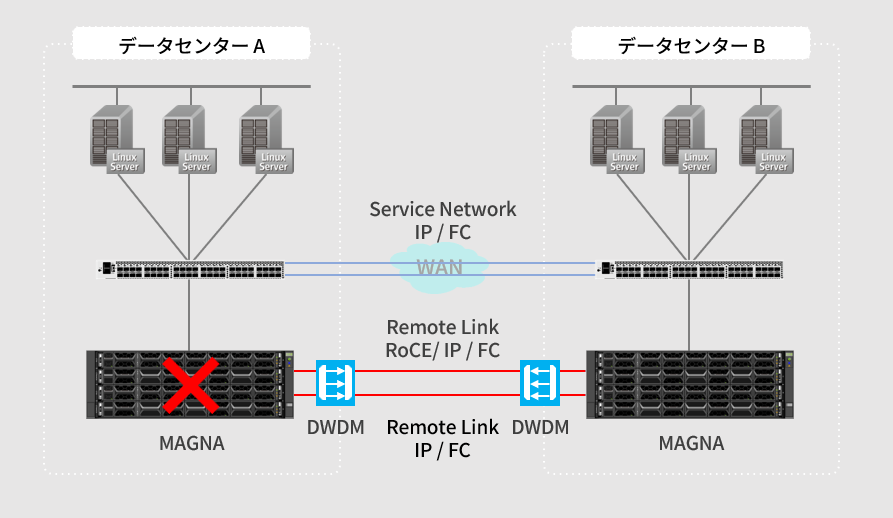

同一都市内:Preferred Storage System Mode

Preferred Storage System Modeは、比較的近距離で2つの拠点間のRTTがおよそ1ms程度の場合に利用します。

通常運用時はローカル接続のMAGNAに対してアクセスし、障害発生時には稼働中のストレージへ切り替えます。

DC間のRemote Linkは、DWDM(dense wavelength division multiplexing)の利用が必須です。

Metro Arbitration Mode for SAN

Metroは片系のストレージ障害発生時の調整モードとして、Static Priority ModeとQuorum Server Modeの2種類から選択できます。Quorum Server Modeは、Static Priority Modeより優れた可用性を提供します。

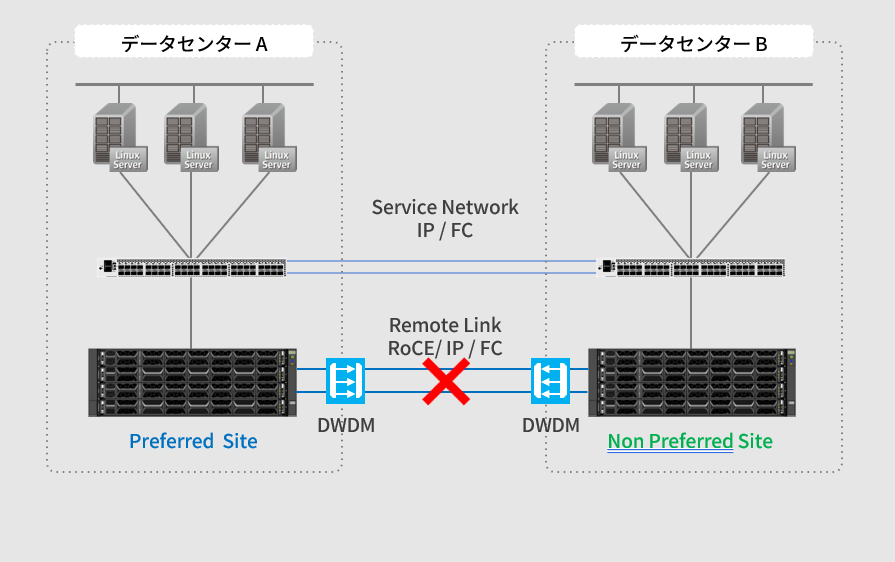

Static Priority Mode

Static Priority Modeは、MetroペアのいずれかのSite(DC)を優先サイトとして設定し、もう一方を非優先サイトとして設定します。

ストレージアレイ間でハートビートの中断が発生した場合、常に優先サイトがサービス提供ストレージとして選定されます。

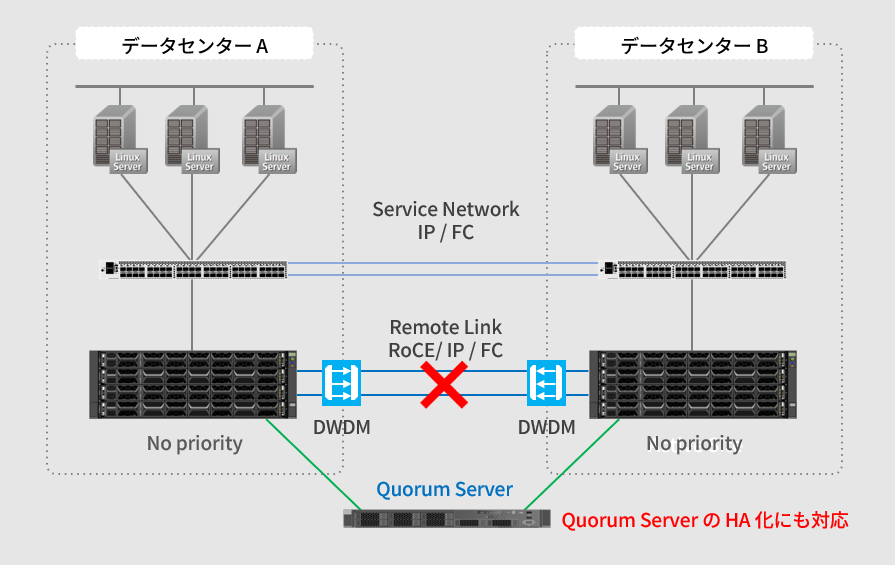

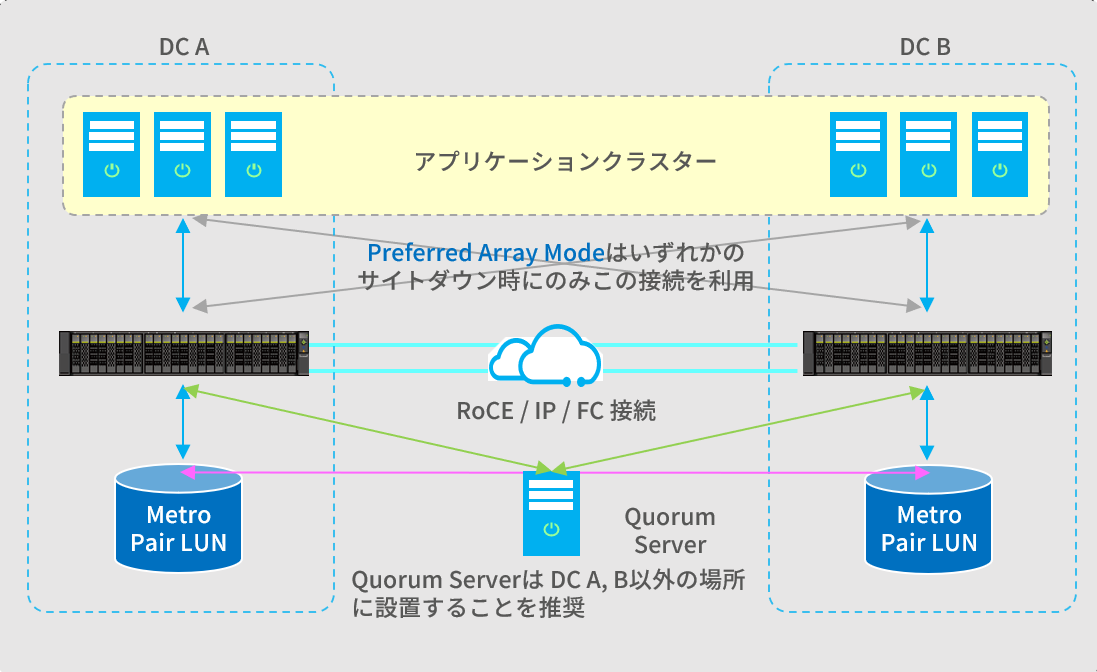

Quorum Server Mode

Quorum Serverは、アレイ間のハートビートが切断されると、サービスを継続させるストレージアレイを動的に決定します。

すべてのQuorum Serverが故障するかQuorum Serverへのリンクが切断されると、自動的にStatic Priority Modeに切り替わります。

DC間のRemote Linkは、DWDM(dense wavelength division multiplexing)の利用が必須です。

Metro for SAN Active-Active Access

Metroは、サイト間でデータの完全ミラーによる真の Active-Activeアクセスを実現します。

-

ストレージデバイス障害またはDCサイト障害に対して、RTOおよびRPOを限りなくゼロにする高可用性ソリューションです

-

Metro Pair LUNは、同一のWWNを有し、データはリアルタイムに同期されており、それぞれのサイトで同時アクセスを実現します

-

同一DC内での利用は遅延が少ないためLoad Balancing Modeを推奨し、DC間での利用はPreferred Array Modeを推奨します

-

シンプルな構成のStatic Priority Modeと、高可用性を提供するQuorum Server Modeの2種類の展開モードを選択可能です

Static Priority Mode

DC AをPreferred Siteとして設定した場合、DC Bのダウン時はDC Aでサービスが継続されるが、DC Aがダウンした場合は、手動によりDC Bでサービスを起動する必要あり

Quorum Server Mode

Quorum Serverにより正常なサイトが調整されるため、いずれのDCがダウンしてもアクセスが継続される高可用性展開モード(Quorum ServerをHA化することで、更なる可用性の向上が可能)

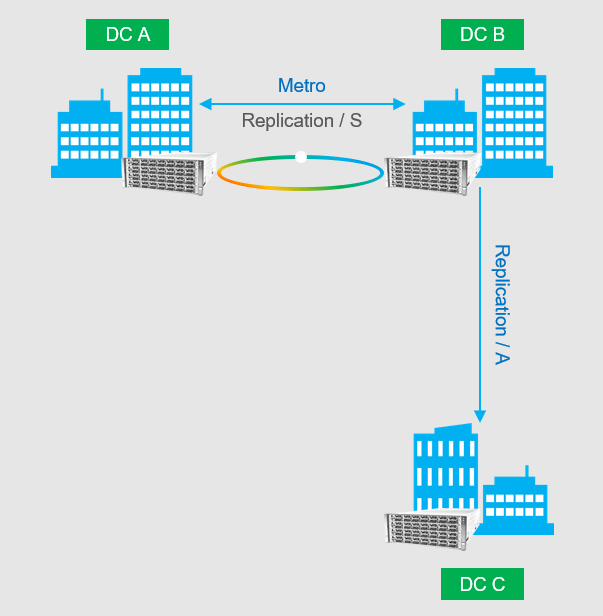

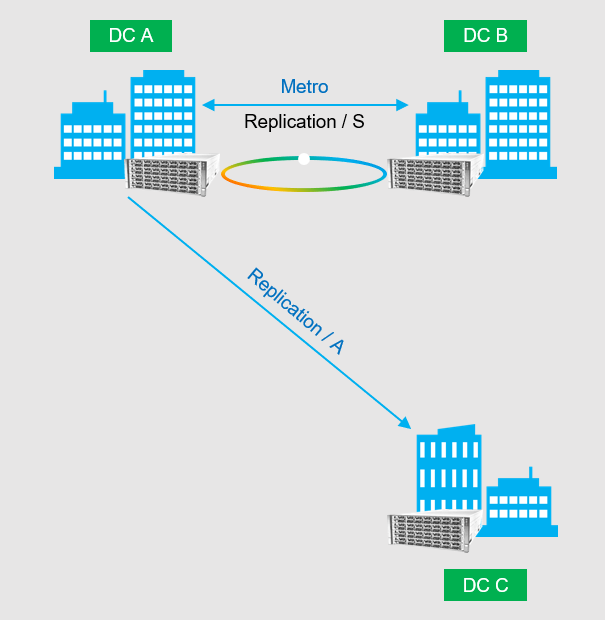

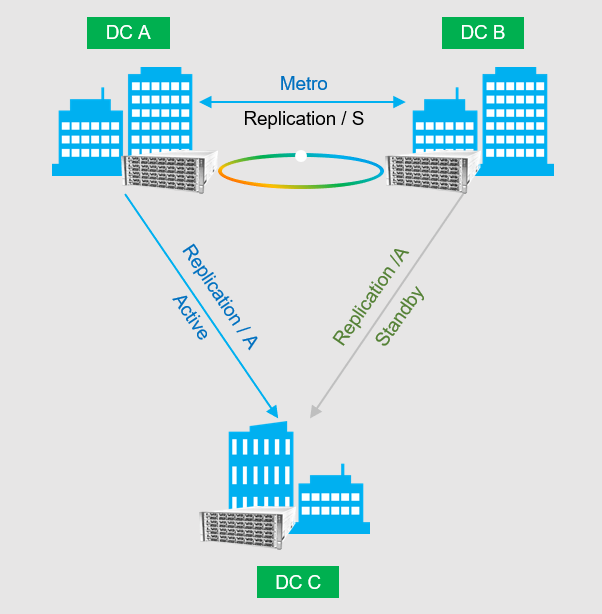

DR Star for SAN

MAGNAは、3DCによる耐災害ソリューションとして複数の展開モードをサポートします。特にMetroと Replication / Aを組み合わせたRingモードであるDR Starは高い可用性と柔軟な運用性を提供します。

-

Cascaded Network Topology Mode

運用サイトDC Aの都市間ミラーサイトとなるDC Bから遠距離サイトのDC Cへレプリケーションを実施

-

Parallel Network Topology Mode

運用サイトDC Aから遠距離サイトのDC Cへレプリケーションを実施

-

Ring Network Topology Mode(DR Star)

DC AとDC Bの双方から遠距離サイトのDC CへActive-Standby構成でレプリケーションを実施